Long Short-Term Memory

Questo tipo di rete cerca di migliorare le RNN

- È una rete universale nel senso che può riprodurre qualsiasi algoritmo

- ha vinto premi per riconoscimento scrittura e riconoscimento voce

Nelle reti RNN è possibile memorizzare l'output di alcuni neuroni (facendolo tornare indietro), ma solo per un passo di tempo discreto. Ben presto il valore fornito da un neurone viene mescolato insieme agli altri ed è difficile tenerne conto per l'addestramento.

Viceversa anche i pesi delle RNN cambiano ma molto più lentamente

Questo tipo di rete cerca di allungare la memoria dei neuroni di ben 10 volte o anche più.

Al posto di un neurone di stato (con memoria), contiene un blocco con una struttura che permette di conservare più a lungo le informazioni

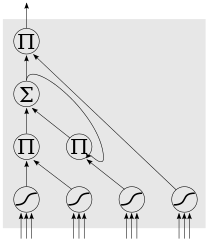

Vediamo in dettaglio i blocchi

La cella centrale (SIGMA) funge da memoria, infatti ha un anello su se stessa.

In basso ci sono gli ingressi, con funzione attivazione logistic sigmoid

Percorrendoli da sinistra verso destra:

- input dei dati da elaborare

- input gate: ha il potere di modificare il peso della connessione tra esterno e interno del blocco, cioè di decidere quando qualcosa deve entrare nel blocco

- fattore?

- output gate: ha il potere di modificare il peso della connessione tra interno ed esterno del blocco, cioè di decidere quando qualcosa deve uscire dal blocco